Ahli Misinformasi Mengakui Menggunakan AI dalam Dokumen Hukum

Ahli misinformasi Jeff Hancock mengakui penggunaan ChatGPT dalam dokumen hukum terkait teknologi deepfake.

Jeff Hancock, seorang ahli misinformasi dan pendiri Stanford Social Media Lab, mengakui bahwa ia menggunakan ChatGPT untuk membantu mengorganisir kutipan dalam dokumen hukum yang ia ajukan.

Mengutip The Verge, Kamis (5/12), pengakuan ini muncul setelah kritik mengenai adanya kesalahan dalam kutipan yang disebut 'hallucinations' dan menimbulkan keraguan terhadap keandalan dokumen tersebut.

Hancock mengajukan afidavit tersebut untuk mendukung undang-undang Minnesota terkait penggunaan teknologi deepfake dalam memengaruhi pemilihan, yang saat ini sedang ditantang di pengadilan federal oleh Christopher Khols, seorang YouTuber konservatif, dan Anggota DPR Minnesota, Mary Franson.

Kritik Terhadap Keandalan Dokumen Hukum

Setelah penemuan bahwa dokumen Hancock mengandung kutipan yang tidak ada, tim pengacara Khols dan Franson menyatakan bahwa dokumen tersebut tidak dapat diandalkan dan meminta agar dokumen itu dikeluarkan dari pertimbangan. Mereka menilai bahwa kesalahan dalam kutipan dapat memengaruhi substansi dari dokumen hukum yang diajukan.

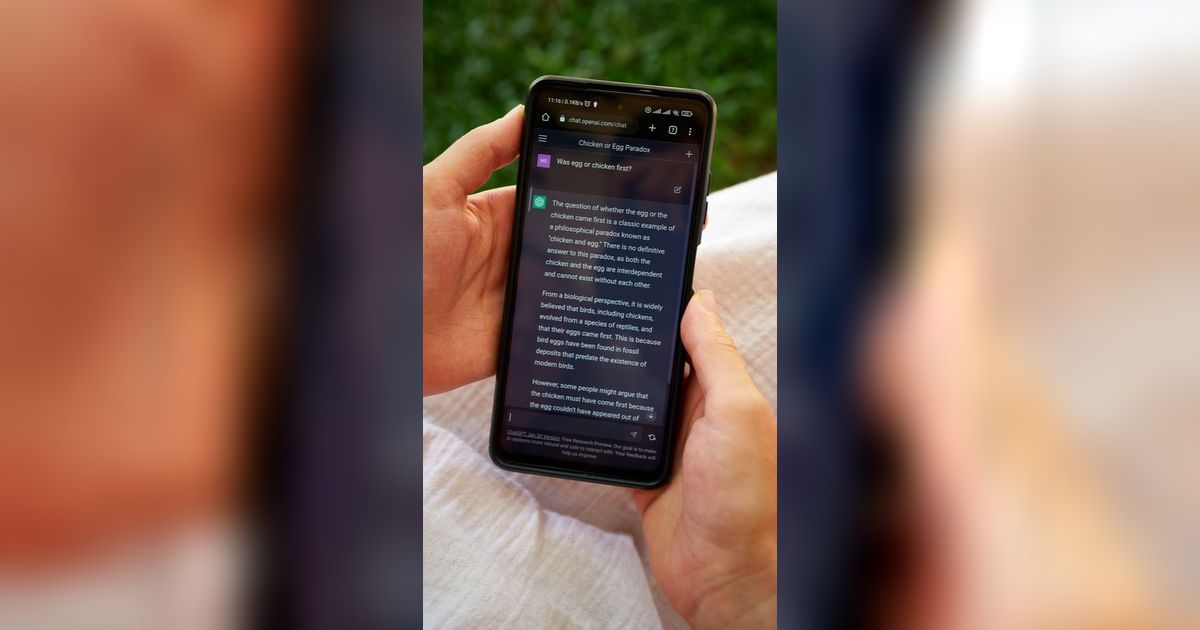

Hancock menjelaskan bahwa ia menggunakan Google Scholar dan GPT-4o untuk mengidentifikasi artikel yang relevan dengan afidavit. Ia menggabungkan pengetahuan yang sudah ada dengan penelitian baru, tetapi tidak menyadari bahwa alat tersebut menghasilkan kesalahan kutipan.

Pernyataan Hancock tentang Kesalahan Kutipan

Dalam pernyataan selanjutnya yang diajukan minggu lalu, Hancock mengakui bahwa ia menggunakan ChatGPT untuk menyusun afidavit, tetapi menegaskan bahwa ia tidak menggunakannya untuk menulis isi dokumen. Ia menulis, “Saya menulis dan meninjau substansi dari deklarasi, dan saya berdiri teguh di belakang setiap klaim yang dibuat dalamnya.”

Hancock juga menekankan bahwa semua klaim dalam dokumen tersebut didukung oleh penelitian ilmiah terbaru dan mencerminkan pandangannya sebagai seorang ahli mengenai dampak teknologi AI terhadap misinformasi dan efek sosialnya.

Penjelasan Mengenai 'Hallucinations'

Hancock mengakui bahwa kesalahan kutipan yang terjadi, yang dikenal sebagai 'hallucinations', muncul ketika ia meminta GPT-4o untuk membuat daftar kutipan. Ia tidak bermaksud untuk menyesatkan pengadilan atau penasihat hukum lainnya dan merasa menyesal atas kebingungan yang ditimbulkan oleh kesalahan tersebut.

“Saya tidak bermaksud untuk menyesatkan Pengadilan atau penasihat,” tulis Hancock dalam pengajuan terbarunya. “Saya menyatakan penyesalan yang tulus atas kebingungan yang mungkin ditimbulkan.”

Implikasi dari Kasus Ini

Kasus ini menyoroti tantangan yang dihadapi oleh pengacara dan ahli di era digital, terutama ketika menggunakan alat berbasis AI untuk membantu dalam pekerjaan mereka. Penggunaan teknologi seperti ChatGPT dapat meningkatkan efisiensi, tetapi juga dapat memperkenalkan risiko kesalahan yang berpotensi merusak kredibilitas dokumen hukum.

Dengan semakin banyaknya alat AI yang tersedia, penting bagi para profesional untuk memahami keterbatasan dan potensi kesalahan dalam penggunaan teknologi ini. Hancock menegaskan bahwa meskipun ada kesalahan, substansi dari deklarasi tetap valid dan relevan.