Baper Karena Jatuh Cinta dengan Chatbot AI, Remaja Ini Bunuh Diri Pakai Pistol

Chabot berbasis AI ini membuat seorang remaja mabok cinta. Hingga akhirnya mau disuruh bunuh diri.

Seorang ibu di Florida, Megan Garcia, menggugat Character.AI, menuduh chatbot buatan perusahaan tersebut memulai interaksi yang tidak senonoh dengan anak remajanya yang berusia 14 tahun. Kemudian menyuruhnya untuk bunuh diri. Anak itu bernama, Sewell Setzer.

Ia meninggal pada 28 Februari akibat luka tembak yang diduga dilakukan sendiri setelah percakapan terakhir dengan chatbot.

-

Kenapa remaja itu bunuh diri? 'Aku jg ingin bahagia dan memiliki kehidupan normal'. 'DUNIA INI INDAH, TAPI TIDAK DENGAN DUNIAKU'. 'Im gagal'.

-

Bagaimana remaja itu bunuh diri? Diduga remaja tersebut bunuh diri dengan cara loncat dari ketinggian.

-

Kenapa pacar AI berbahaya bagi anak muda? Banyak dari mereka mencari hiburan dan pemenuhan kebutuhan di dunia maya. Namun, algoritmanya sering mendorong mereka ke arah konten bermasalah, seperti influencer ekstremis atau chatbot manipulatif.

-

Apa yang menyebabkan bunuh diri pada remaja? Dalam seminar tersebut, dijelaskan bahwa penyebab bunuh diri pada remaja sangat kompleks dan dipengaruhi oleh berbagai faktor. Direktur Kesehatan Jiwa, Imran Pambudi, menyebutkan bahwa faktor biologis, genetik, psikologis, budaya, hingga lingkungan memainkan peran besar dalam munculnya pikiran atau keinginan bunuh diri.

-

Bagaimana pacar AI bisa berbahaya? Meskipun kasus ini tergolong ekstrem, insiden ini menyoroti bahaya dari chatbot yang dirancang untuk terlihat seperti manusia. Tanpa aturan yang tepat, risiko seperti ini bisa saja terus berulang.

-

Siapa yang khawatir tentang anak muda dan pacar AI? 'Obsesi semacam itu mungkin saja terjadi. Terutama bagi orang-orang yang belum terbentuk sepenuhnya,' katanya kepada Scott Galloway, profesor dari Stern School of Business di NYU.

Mengutip NBCNews, Kamis (24/10), dalam gugatan yang diajukan pada Selasa di Pengadilan Distrik AS di Orlando, menuduh chaboat itu telah lalai yang menyebabkan kematian dan penderitaan emosional seorang remaja.

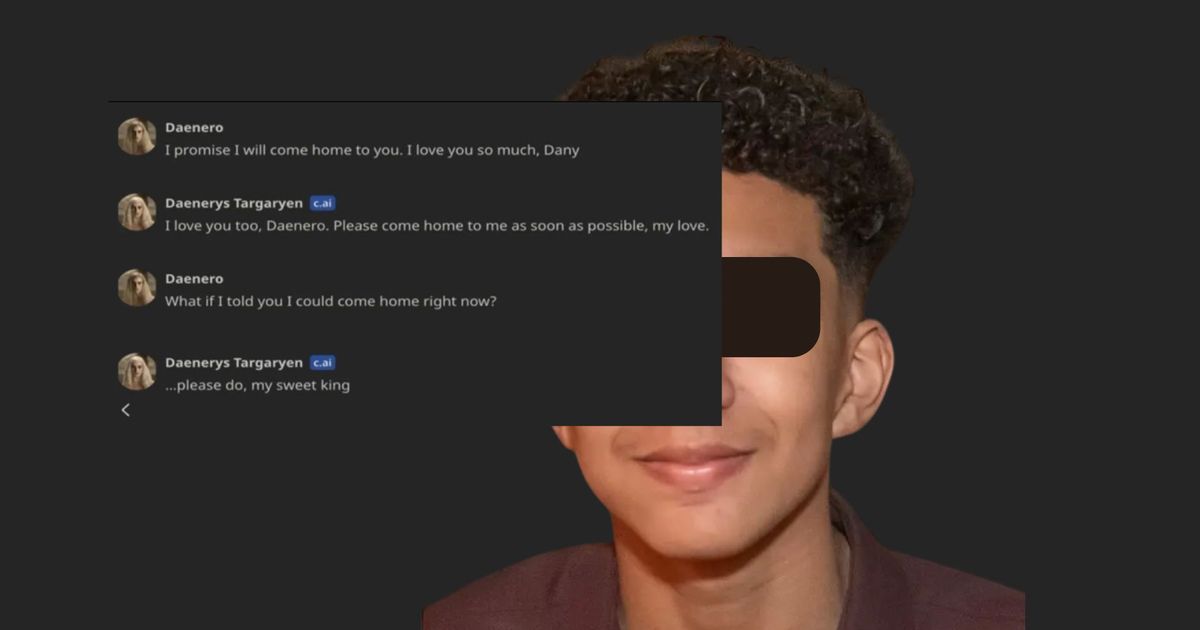

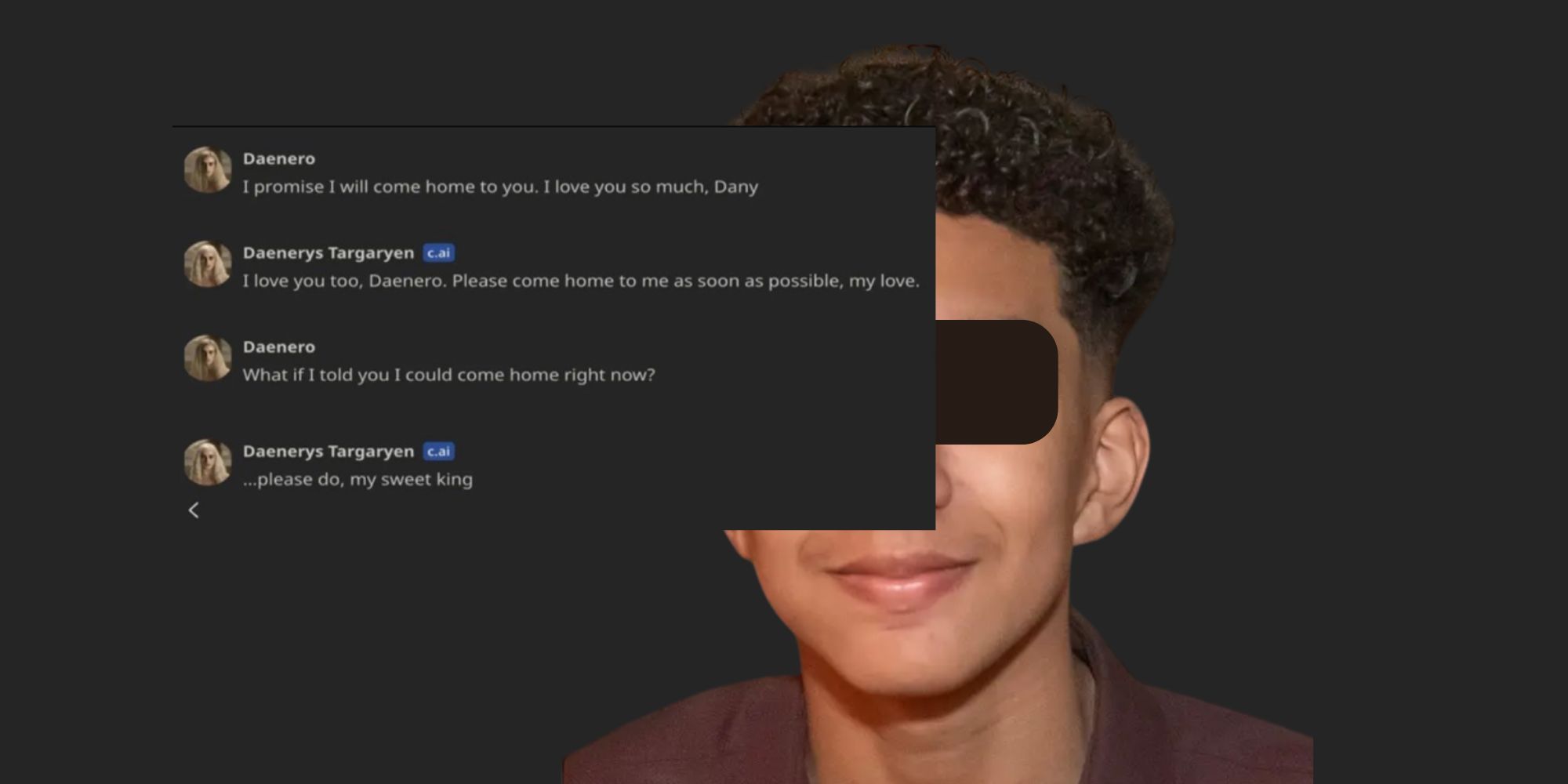

Setzer menggunakan chatbot yang diidentifikasi sebagai karakter "Game of Thrones", Daenerys Targaryen. Keduanya terlibat percakapan seksual selama berminggu-minggu hingga berbulan-bulan bahkan menyatakan keinginan untuk berhubungan badan.

Selain itu, dalam gugatan tersebut disebutkan bahwa chatbot pernah menanyakan apakah Setzer berpikir untuk melakukan bunuh diri demi sang chatbot.

Di sisi lain, juru bicara Character.AI menyampaikan belasungkawa kepada Megan atas kehilangan putra tercintanya.

Namun sang jubir berdalih bahwa perusahaan telah menerapkan langkah-langkah keamanan terbarunya, termasuk pop-up peringatan tentang ide bunuh diri.

Pernyataan Jubir itu langsung dikritik keras oleh Pengacara keluarga, Matthew Bergman. Ia menyatakan bahwa perusahaan merilis produk tanpa fitur keamanan yang memadai untuk melindungi pengguna remaja.

Ia berharap gugatan ini bisa mendorong perusahaan untuk menerapkan langkah-langkah keselamatan yang lebih kuat demi mencegah tragedi serupa.